ETL 뿐만 아니라 메타데이타·데이터 품질 등 연계 적극 모색

[컴퓨터월드] 빅데이터 시대, 빅데이터 처리와 분석을 위한 플랫폼 시장에서 ‘하둡(Hadoop)’을 빼놓고는 이야기할 수 없을 정도로 중요한 역할을 차지하고 있다. 하둡은 대용량 데이터를 값싸고 빠르게 분석할 수 있는 길을 만들어줬고, 실제 비용과 시간 때문에 다루지 않았던 데이터까지 분석할 수 있는 환경을 만들었다. 또한 통계분석엔진인 ‘R’ 역시 하둡 못지않게 관심을 끌고 있다.

그러나 ‘빅데이터’ 역시 ‘데이터’라는 점을 놓고 볼 때 ‘하둡’과 ‘R’을 활용해 분산처리와 분석 그 이전에 데이터 품질 등 데이터 거버넌스가 이뤄지지 않고서는 제대로 된 결과물을 얻기는 힘들다.

그런 점에서 주목받지 못하지만 정보시스템 상에서 앞단 작업에 선봉에 있는 ETL은 빅데이터 시대 숨은 공로자와 같은 존재다. 관련 업계 전문가들은 ETL을 정보시스템의 ‘피’와 같은 존재로 결코 무시해서도 소홀히 해서도 안 되는 매우 중요한 핵심 기능이라고 강조한다.

빅데이터 시대, 정보시스템의 기본 기능 중 하나인 ‘ETL’의 중요성과 환경 변화에 따른 진화의 모습을 살펴본다.

경기 침체 속에 기업들은 생존을 위해 경쟁력을 갖추기 위한 노력을 기울이고 있다. 우선 기업들은 IT 투자 및 운영에 ‘효율’이라는 과제를 던지게 됐으며, 성능이 아닌 총소유비용(TCO : Total Cost of Ownership)에 맞춰 기업 내 정보시스템을 구축·운영하려는 노력을 하고 있다.

기업의 정확한 비즈니스 의사 결정을 위해 사용하는 데이터 접근, 수집, 보관, 분석 등의 애플리케이션과 기술의 집합인 비즈니스 인텔리전스(BI) 역시 변화가 감지되고 있다.

기업들은 기업 간 경쟁에서 우위를 점하기 위해 기업 시스템 내 다듬어진 데이터를 활용한 분석뿐만 아니라 그동안 다루지 않았던 로그 데이터, 페이스북·트위터 상에서 생성되는 SNS(Social Networking Service) 데이터까지 분석 해 경쟁력 강화를 위한 해답을 얻기 위한 방법을 고민하고 있다.

또한 그동안 과거 데이터를 분석했다면 이제는 현재와 미래를 파악하고 예측하기 위해 실시간으로 데이터에 접근 또는 분석을 통해 기업의 발 빠른 대응을 하기 위한 정보시스템 구축에도 나서고 있다.

BI 시스템의 숨겨진 핵심 기능 ‘ETL’

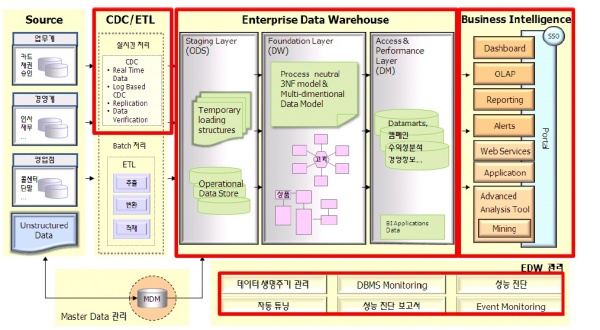

BI는 기업들의 의사 결정 지원 시스템, 조회 및 응답, 올랩(OLAP), 통계 분석, 예측 및 데이터 마이닝 등 기본 요소와 함께 기업의 데이터베이스와 데이터웨어하우스(DW), 전사적자원관리(ERP) 등과 연계를 필연적으로 하는 기업 정보시스템 그 자체로 볼 수 있다.

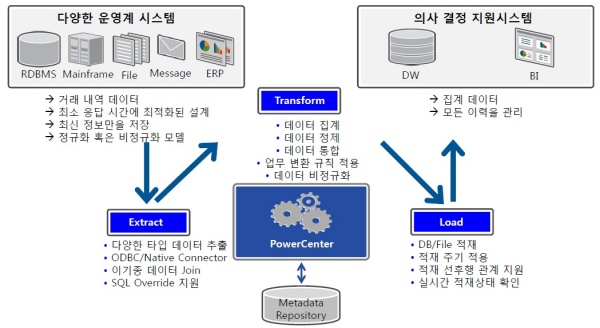

그 중 ‘ETL(Extract Transform Load)’은 BI 시스템 내 중요한 역할을 담당한다.

ETL은 기업 시스템 내에 축적된 데이터 중 A 시스템에 데이터를 추출(Extract), 데이터웨어하우스 등에서 이용하기 쉬운 형태로 변환(Transform)해, 대상이 되는 B 시스템에 적재(Load) 또는 이들 일련의 처리 지원하는 용도로 쓰인다. 이렇게 처리된 데이터는 시각화(visualization) 작업을 통해 기업 의사결정권자들을 위한 비즈니스 리포트로 만들어진다.

“ETL은 1990년대 말 본격적으로 도입됐으며, 그 당시 데이터를 일(日) 단위 또는 월(月) 단위 등 일정 기간 데이터를 모아두었다가 한꺼번에 처리하는 배치처리(Batch Processing)를 위해 탄생했다”는 인포매티카 임정혜 부장 말처럼 보통 단건 처리 위주의 기간계보다는 통계 데이터 생성이 주업무인 정보계 시스템 내 데이터를 추출해 DW에 적재하는 용도로 사용된다.

이런 ETL을 쉽게 할 수 있는 도구가 등장해 단기간에 간편히 ETL 시스템을 구축할 수 있게 됐다. ETL 툴에는 그래픽사용자인터페이스(GUI)를 사용해 데이터의 흐름을 가시화하고 구축하는 툴이나, 데이터 형식의 변환기능, 부정 데이터를 배제한 일정 형식으로 데이터를 수정하는 데이터 클렌징 기능 등이 탑재돼 있다. 실제 ETL 작업이 전체 작업의 반절 이상을 차지 할 만큼 BI 시스템에서 중요한 역할을 했지만 전통적인 데이터 처리 과정에서 봤을 때 ETL은 금융과 대규모 정형 데이터를 처리하는 기업에서만 찾는 제한적인 기능이었다. 데이터 규모가 크지 않는 기업들은 수작업을 통해 데이터를 코딩했기 때문에 ETL 툴 같은 상용 제품을 굳이 구매할 이유는 없었다.

빅데이터 시대, ‘ETL’ 툴 필수요소로 자리 잡다

그러나 IT 시장에서 대규모의 다양한 데이터를 활용하는 ‘빅데이터’가 화두로 떠오르기 시작하면서, ETL 툴에 대한 인식이 변했다.

지금껏 기업 내부 시스템 내 데이터는 비교적 잘 가공된 구조화 데이터 및 반구조화 데이터이면서 데이터 규모가 크지 않았기 때문에 추출해 변환, 적재하는 일은 시간이 소요될 뿐 난이도가 높은 작업은 아니었다.

그러나 데이터의 폭발적 증가와 함께 구조화·반구조화 데이터 뿐만 아니라 기존에 다루지 않았던 비구조화 데이터까지 처리해야 하는 상황에서 일일이 수많은 데이터를 기업 데이터 포맷으로 코딩해야하는 상황은 더 이상 쉬운 일이 아니게 됐다. 이에 직접 코딩하지 않아도 되는 ETL 툴이 적극적으로 도입되기 시작했다.

이 같은 대표적 사례로 ETL 툴의 ‘하둡(Hadoop : High-Availability Distributed Object-Oriented Platform)’ 지원을 들 수 있다.

즉, 기존에는 관계형 DB에서 데이터를 추출해 관계형 DB에 올리는 역할을 하던 ETL이 이제는 관계형 DB가 아닌 비구조화 데이터를 처리하는 대표적인 플랫폼인 ‘하둡’과 같은 파일시스템까지 지원해야 하는 상황에 놓인 것이다.

실제 국내 시장에서 ETL 툴 시장은 △데이터스트림즈-테라스트림(TeraStream) △한국IBM- 인포스피어 데이터스테이지(InfoSphere DataStage) △한국오라클-ODI(Oracle Data Integrator) △한국인포매티카-인포매티카 파워센터(Informatica PowerCenter) 등 4개사가 경쟁하고 있다. 이들은 하둡에 대응하는 ETL 솔루션을 출시하거나 기능을 추가해 시장에 대응하고 있다.

△데이터스트림즈 테라스트림 포 하둡(TeraStream for Hadoop) △한국IBM 인포스피어 데이터스테이지 9.1 버전 △한국인포매티카 파워센터 빅데이터 에디션(Informatica PowerCenter Big Data Edition)·파워익스체인지 포 하둡(PowerExchange for Hadoop) 등이 그것이다.

ETL, ‘데이터 거버넌스’ 선봉에 서다

BI 시스템 흐름 상 ETL은 시작을 담당하는 전초부대와 같다. 데이터의 추출·변환·적재가 이뤄져야 분석이 이뤄지기 때문이다. 빅데이터 분석 역시 구조화 및 비구조 데이터가 구조화 데이터로 변환·적재가 이뤄져야 분석이 가능하다.

오라클 정광연 상무는 “ETL은 더 이상 ‘ETL’이 아닌 ‘Integration’으로 불리고 있다”며, “ETL은 단순히 추출·변환·적재 기능 도구일 뿐만 아니라 데이터 품질과 메타데이터 등 데이터 통합(Data Integration)의 핵심요소로 진화를 거듭하고 있다”고 설명했다.

즉, 데이터의 품질이 좋아야 제대로 된 분석 결과를 얻을 수 있다는 점에서 구조화 데이터 외 비구조화 데이터 역시 품질이 확보돼야 정확한 분석 결과를 얻을 수 있다. 이런 흐름에 맞춰단순 추출·변환·적재 기능뿐만 아니라 메타데이터와 데이터 품질까지 포함해 데이터를 거버넌스 하는 식으로 시장의 요구 상황에 맞춰 ETL 툴 보유 기업이 이런 전략을 취하고 있다.

다만 이런 ETL의 진화가 국내에서는 다소 더디게 흘러가고 있다. ETL의 툴이 선보인지 20년이 지났지만 그동안 ETL 툴은 BI 시스템 기본 요소로 시장 규모 자체가 커지긴 했지만 국내 사정을 감안했을 때 성숙되어 있다고 보기는 힘들다.

IBM 최석재 차장은 “외국의 경우 ETL이 데이터 거버넌스 위주로 가고 있다면, 아직 국내에서는 ETL을 데이터 추출 용도로만 활용하고 있는 것처럼 전체 기능 중 10~20% 밖에 활용하지 못하고 있다. 메타데이터와 데이터 품질과 통합보다는 각기 다른 솔루션을 도입해 연계성이 매우 낮은 게 현실이다”라고 설명했다.

최 차장은 “그나마 최근 들어 국내 큰 규모의 기업들 중심으로 ETL을 데이터 통합 용도로 쓰기 위한 움직임에 나서 곧 국내도 외국과 같은 거버넌스 개념으로 ETL을 활용하게 될 것으로 전망된다”고 밝혔다.

실제 ETL 툴을 보유한 국내 4개사의 전략을 살펴보더라도 이런 흐름을 쉽게 파악할 수 있다.

국산 ETL 전문 기업인 데이터스트림즈는 그동안 데이터 통합 매니지먼트 전문 기업으로 이름을 알렸지만, 메타데이터 기반의 전사적 데이터관리 서비스 아키텍처인 ‘mDOSA’ 전략을 늘 강조하고 있다. mDOSA는 전사적으로 데이터 생성 시점부터 활용, 폐기하는 전 단계의 데이터를 관리하도록 개발된 플랫폼이다.

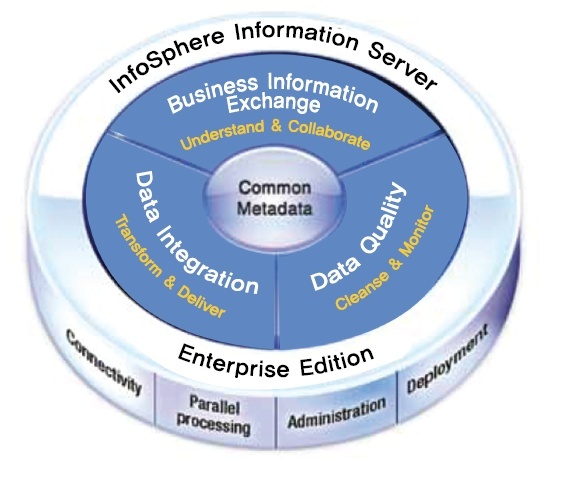

한국IBM 역시 지난 2006년 기업 내에 산재한 정보들을 효율적으로 통합, 관리, 활용할 수 있도록 하는 데이터 통합 플랫폼인 ‘IBM 인포메이션 서버’를 국내 출시했다. 인포메이션 서버는 IBM이 인수한 어센셜(Ascential), 베네티카(Venetica), 유니콘(Unicorn), 크로스액세스(CrossAccess) 등 여러 기업들과 IBM의 정보통합 기술을 기반으로 만들어진 솔루션이다.

한국오라클 역시 ODI(Oracle Data Integrator)·OGG(Oracle GoldenGate)·ODQ(Oracle Data Quality)을 연계한 오라클 데이터 인티그레이션 솔루션 플랫폼을 보유하고 있다.

한국인포매티카도 인포매티카 대표적 데이터 통합솔루션 ‘인포매티카 파워센터’가 DW, 데이터 거버넌스, 데이터 마이그레이션, SOA(Service-Oriented Architecture), B2B 데이터 교환 및 마스터데이터관리(MDM) 등을 비롯한 모든 전사적 통합 프로젝트를 위한 데이터 통합 토대 역할을 담당하고 있다.

데이터스트림즈 이광복 부장은 “ETL 툴을 결국 모든 데이터 방식에 대해 자동으로 처리할 수 있는 방식으로 확대될 것이다”고 말한 것처럼 ETL 툴은 하둡과 같이 비구조화 데이터는 물론 새로운 프로그램 방식으로 각종 데이터 방식이 다양해지고 있는 시장 상황에 맞춰 다양한 데이터에 대한 처리 기능을 유연하게 추출해 변환시킬 수 있는 기능을 향상시키고 있다.

뿐만 아니라 그동안 ETL 툴의 배치처리라는 기능에서 탈피, 실시간 처리라는 환경적 변화를 겪고 있다. 그동안 하루에 한두 번 배치처리하던 정보계를 이제는 2~3시간에 한 번씩 배치처리하는 식으로 실시간으로 이뤄지고 있다.

오라클 박대규 부장은 “ETL 배치처리의 기본 개념은 하루였다. 이 개념이 데이터 폭증으로 변화하기 시작하고 있다”고 언급하며, “과거 ETL 배치처리가 6시간 동안 100GB(GigaByte)이었다면, 이제는 1TB(TeraByte) 이상 처리하는 기업이 생기고 있다”고 설명했다.

IBM 최석채 차장은 “하루에 한 번씩 배치처리했던 상황에서 이제는 2~3시간만에 배치처리를 하는 식으로 변하고 있다. 심지어 증권사의 경우는 실시간 배치처리를 하고 있다”며, “전날 데이터가 아니라 실시간 데이터를 보려고 하는 고객들의 요구사항이 늘어나고 있다”고 밝혔다.

이처럼 그동안 DW에 데이터를 배치해 분석한 결과는 전날 데이터를 바라본 것으로 현재가 아닌 과거 데이터일 수밖에 없었다. 그러나 이제는 실시간 데이터를 보고자 하는 요구가 강해짐에 따라서 ETL 툴 역시 실시간 추출·변환·적재하는데 집중하고 있다는 것이다.

IBM 최석채 차장은 “점점 EAI와 ETL 경계가 무너지고 있다”며, “대용량 처리, 데이터 정합성, 다양한 변환기능이 결합된 실시간 솔루션이 나올 것으로 전망된다”고 밝혔다.

그동안 IT 시장에서 ETL은 신기술과 표면적으로 드러난 솔루션에 밀려 조명을 받지 못했다. 그러나 실제 정보시스템 내 중요한 역할을 담당하고 있고, 결과를 얻기 위한 선요구 과정으로 진화 과정을 거쳤다.

ETL은 과거 일(日) 단위 데이터 추출·변환·적재에서 실시간 데이터 추출·변환·적재로, 그리고 관계형DB처럼 구조화·반구조화 데이터에서 하둡과 같은 비구조화 데이터까지 처리할 수 있는 영역을 넓히고 속도를 빠르게 하는 등 아직도 진화하고 있다.

| IBM 인포스피어 데이터스테이지(InfoSphere DataStage)

▲ IBM 인포스피어 인포메이션 서버

인포스피어 데이터스테이지의 최대 강점은 병렬처리 기반의 ETL 툴로 성능이 뛰어나다는 점이다. 이에 스케일업, 스케일아웃 어떤 방식으로 서버를 확장하더라도 IBM ETL 툴 또한 선형적으로 확장시킬 수 있다는 것이다. 또한 개발된 모든 내용이 메타데이타화되어 영향도 분석 및 데이터 계보 분석이 용이하다. 워크로드 관리 기능이 있어 시스템 자원 활용을 제어하거나 작업의 우선순위를 주어 실 환경에 유연하게 대처가 가능하다. 게다가 IBM은 ETL툴 뿐만 아니라 데이터를 통합, 관리, 활용할 수 있는 데이터 통합 플랫폼인 ‘IBM 인포메이션 서버’를 보유하고 있어, 포괄적인 정보 통합으로 정보를 쉽게 통보할 수 있는 패키지를 제공한다. |

|

데이터스트림즈

▲ 테라스트림

유일한 국산 ETL 툴 보유 기업인 데이터스트림즈는 美 IRI사의 데이터 정렬(Sorting) 및 변형(Trans-formation)을 위한 핵심엔진인 코소트(CoSORT)를 유통 경험을 바탕으로 ETL 시장에 뛰어들었다. 이후 데이터스트림즈는 다양한 데이터를 추출•변환•전송을 비롯한 종합 배치처리 솔루션인 자체 솔루션인 '테라스트림'을 선보이며 금융권을 중심으로 국내 ETL 시장에서 국산 SW 기업의 저력을 보인 기업으로 평가 받는다.

테라스트림은 IBM, 인포매티카의 DB 로드 방식이 아닌 파일 로드 방식으로 데이터를 추출·적재할 때만 부하를 주는 식으로 DB 부하를 막기 위한 방식으로 특화를 했다. 이를 두고 데이터스트림즈는 기존 DB 방식의 문제점을 극복하고자 만든 것이 테라스트림이라고 설명한다. 또한 ETL 첫 번째 프로세스인 추출을 위한 별도의 추출엔진인 FACT를 탑재했으며, 가공 부분에서도 파일 처리 기반으로 만들어져 성능이 우수하다는 점이 장점이다. 데이터스트림즈는 테라스트림 등 데이터 통합 및 데이터 품질 기술을 바탕으로 각각의 패키지 제품 판매 중심에서 벗어나, 기업의 다양한 데이터에 관한 요구를 반영한 데이터 거버넌스 아키텍처(mDOSA) 전략을 주창하고 있다. mDOSA는 기업 내외부에서 수집되는 데이터를 정제화하는 ETL과 단일화된 표준으로 데이터를 관리해 쉽게 활용할 수 있도록 한다. 통합적인 인터페이스와 관리프로세스를 도입함으로써 데이터표준관리 및 품질유지를 개선하고 관제 및 통제 영역을 강화해 일관된 데이터 관리프로세스를 유지하게 해준다. |

|

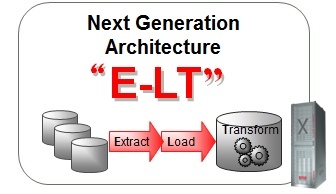

오라클

▲ 오라클 ODI는 ETL이 아닌 E-LT 아키텍처로 차별화 된 전략을 취했다

오라클이 취하고 있는 E-LT 아키텍처는 기존 ETL 툴이 가지고 있는 단점을 극복한 방법이라고 주장한다. 기존 ETL가 추출-변환-적재 과정을 거치며 전용 ETL 서버를 이용한 변환의 경우 전용 엔진 과부하 및 성능의 한계와 유지비용이 크다며, 이를 추출과 로드 후 적재하는 방식으로 RDBMS를 이용한 변환으로 기존 DB 자원을 활용하며 전용 ETL 서버를 둘 필요가 없어 효율을 높이며, 성능이 뛰어나다는 장점이 있다는 게 오라클 측의 설명이다. 또한 소프트웨어와 하드웨어 결합인 엔지니어드 시스템 전략을 펼치고 있는 오라클답게 ODI 뿐만 아니라 OGG(오라클 골든게이트)와 ODQ(오라클 데이터 퀄리티) 등을 통합하며 이를 엑사데이타 내에서 구동하는 방식으로 타 기업보다 보다 빠른 성능을 이끌어낼 수 있다. |

| 인포매티카 인포매티카 파워센터(Informatica PowerCenter)

▲ 인포매티카 파워센터 아키텍처

최근 한국전자통신연구원(ETRI)이 이기종 데이터 융합과 관련 인포매티카와 데이터스트림즈 기술 격차가 2년 난다는 추정 결과를 내놨을 정도로 이 분야에서 인포매티카의 위치는 독보적이라고 할 수 있다. 인포매티카의 주력 제품인 ‘파워센터’는 ETL 툴로 IBM과 오라클과 달리 플랫폼에 중립적으로 독립적인 서비스를 제공한다는 점이 최대 강점이다. IBM과 오라클이 자사 플랫폼 내 구동할 경우 최대 성능이 발휘하는 것에 비해 인포매티카의 파워센터는 고객이 어떤 DB, 미들웨어를 사용하고 있든지 상관없이 고객의 요구를 커스터마이징해서 서비스할 수 있는 등 이기종 간의 환경 내에서도 높은 호환성을 자랑한다. 실제 이런 인포매티카의 전략은 하둡을 기반으로 한 빅데이터 플랫폼 구축 시 굳이 하둡 개발자가 아니더라도 쉽게 개발도구를 다룰 수 있다는 점에서 빛을 발휘하고 있다. |