황대환 ETRI 기술기획부 책임연구원

[컴퓨터월드]

|

AI, 빅데이터 등을 중심으로 4차 산업혁명이 본격 시작됐다. 즉 미래 먹거리 시장을 둘러싼 패권경쟁이 본격화 된 것이다. 다시 말해 4차 산업혁명을 누가 주도해 나가느냐에 따라 국가 산업 및 경제 발전의 향방이 크게 달라질 수 있다는 것이다. 때문에 4차 산업혁명은 반드시 우리나라가 앞장서 나갈 수 있도록 여건을 만들어나가야만 한다는 게 전문가들의 지적이다. 특히 자원이 부족한 반면, 우수한 인력을 갖고 있는 만큼 잘만 하면 그 어느 나라에 못지않게 앞서 나갈 수 있다는 것이다. 통신 기술 및 인프라를 비롯해 SW 기술력 등을 많이 확보해 놓고 있기 때문이라는 것이다. 본지는 이에 따라 국내 ICT 산업 발전의 두뇌역할을 하고 있는 한국전자통신연구원(ETRI)에 의뢰해 미래 먹거리 및 일자리 창출에 지대한 영향을 미칠 것으로 판단되는 주요 아이템을 중심으로 관련 전문가들의 강좌를 1년 동안 게재한다. 즉 그들의 예리한 시각과 분석을 바탕으로 국내는 물론 세계 시장을 주도할 기술, 그 기술에 대한 글로벌 트렌드, 그 기술과 국내 기술과 맞물린 현 상황, 그리고 현안 문제 및 나아갈 방향 등을 짚어본다. <편집자 주> |

|

■ 인간의 삶을 바꾸는 미래 ICT 전망 (2019년 11월호) |

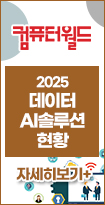

사람은 두 개의 눈으로 주변환경을 총천연색으로 그리고 3차원으로 인식한다. 이 총천연색은 RGB로 구성되며, 태양이 방사하는 파장의 극히 일부인 가시광 대역(400nm~700nm)에 해당한다. 그림(1)은 파장 대역별로 각기 다른 반사 및 투과 특성을 갖는 이미지를 보여주고 있다.

사람이 볼 수 없는 감마선, 엑스레이, 적외선, THz 파장 등은 각기 고유한 특성을 가지고 있는데 이를 이미지로 가시화 할 경우, 다양한 분야의 이미징 응용이 가능하다. 예를 들어 열적외선 대역(MWIR, LWIR)은 물체의 온도를 감지해 별도의 조명 없이 주변 환경을 색온도로 가시화 할 수 있으며 특정 주파수 대역은 구름, 안개등을 통과하는 등 악천후에 강하다는 특성이 있다.

다양한 파장의 특성을 분석해 사람의 인식 한계를 극복하려는 움직임이 있는데 다중파장 영상(Multi-spectral Image), 하이퍼 파장 영상(Hyper-spectral Image) 센싱기술 등으로 그 응용분야로 확대되고 있다. 특히 현재 2차원에 한정된 영상을 실제 세계인 3차원으로 확대하기 위한 기술개발도 활발히 진행되고 있다.

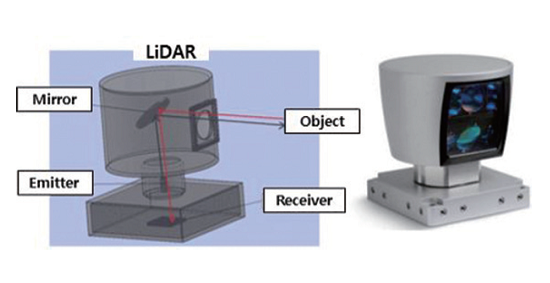

1. LiDAR(Light Detect and Range) 기술

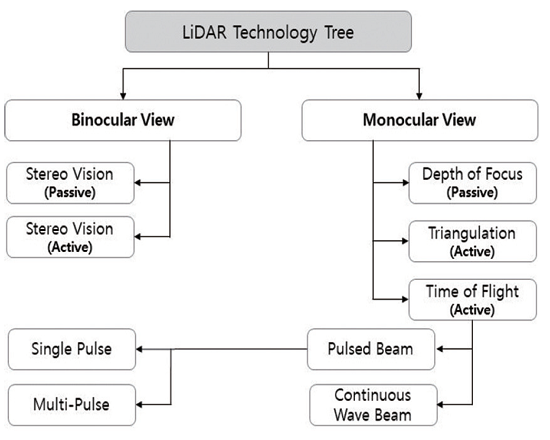

LiDAR는 Radar(Radio Detect and Range)에서 어원 및 방식이 파생되었으며, 빛을 탐지해 거리를 센싱하는 기술을 의미한다. 그림(2)는 LiDAR 기술분류를 보여주고 있다. 크게 눈(카메라)의 개수에 의해 단안기술과 양안기술로 구분된다. 단안기술은 초점으로 거리를 감지하는 방법(Depth of Focus), 임의의 약속한 패턴을 투사하고, 이 패턴을 촬영하여 변이된 값을 삼각법으로 거리를 계산하는 방법(Active Triangle) 그리고 신호를 투사하고 이 투사한 신호의 반사 시간으로 거리를 감지하는 ToF(Time of Flight) 기술 등이 있다.

Active Stereo Vision은 두 개의 카메라를 이용해 거리를 감지할 수 있도록 한다. 빛을 질감(Texture), 무늬(Pattern)에 투사하는 방식으로 촬영하는 영상의 특성에 부합하는 질감/무늬를 원래의 영상의 고유한 특징을 보완하며 투사하는 것이 성능개선의 관건이다.

그림(3)은 자동차, 드론 등의 자율이동을 위해, 주변의 거리를 센싱하여 3차원 Point Cloud 정보로 표현하는 대표적인 LiDAR 기술제품의 형상으로 근적외선(800nm~900nm) 신호를 사용하여 실내외 거리를 측정한다.

그림(4), 그림(5)는 삼각법 측정방식(Active Stereo, Active Mono Vision)과 반사시간을 측정하는 ToF 방식등을 사용하여 카메라 시점에서 주번환경과의 거리를 측정한다. Eye-Safety 측면에서 제한된 광원 투사와 야외 태양광의 영향으로 주로 실내환경에서의 응용으로 그 적용번위가 국한되며, 거리계산을 위한 센서와 RGB 센서를 별도로 실장하여 RGB 영상이 거리영상(Depth Image)과 다른 시점 정보를 갖는다는 단점이 있다.

그림(3)은 실외에서 주야간에 단순 거리값을 계측하는 장치로 안정적으로 동작한다. 그림(4), 그림(5)는 컬러정보를 제공하나, 거리영상이 컬러영상의 시차와 불일치해 실내에서만 사용할 수 있다는 한계가 있다.

2. RGB-LiDAR 기술

RGB-LiDAR는 사람의 눈과 같이 컬러(RGB)와 거리(Depth)를 동시에 시차없이 인식하는 기술로 정의할 수 있다. 사람의 시각인지 방식은 대략 6cm 내외의 수평거리에 따른 시차가 발생하는 입력 영상을 좌우 눈으로 인식한 후 사람의 뇌에서 좌우 입력영상의 동일점 시차를 구분해여 거리정보를 계산하고 컬러 광정보과 거리정보를 융합한 입체감을 갖는 총천연색 컬러 영상으로 인식하는 것으로 알려져 있다.

앞서 기술한 그림(3)은 단순거리를, 그리고 그림(4)와 그림(5)는 거리와 컬러영상을 감지한다. 그러나 이 영상은 별도의 거리 및 컬러 인지용 센서를 임의의 수평축 거리를 두고 실장하여, 컬러와 거리가 일치하는 3D 정보(3D Voxel)는 아니다.

물론 사람의 시각체계를 모사하여 두 개의 렌즈/이미지 센서를 사용하여 RGB 광을 센싱하고, 이 영상의 시차를 계산하여 거리를 구하는 스테레오 비전 방식이 가장 효율적인 RGB-LiDAR의 구현 형태로 볼 수 있으나, 이와 관련된 수십년의 집중적인 연구에도 불구하고, 택스처가 없는 영역, 반복된 패턴, 양안에서 입력되는 조명의 차이등으로 열악한 성능을 보여 제한된 분야에만 적용이 가능한 실정이다.

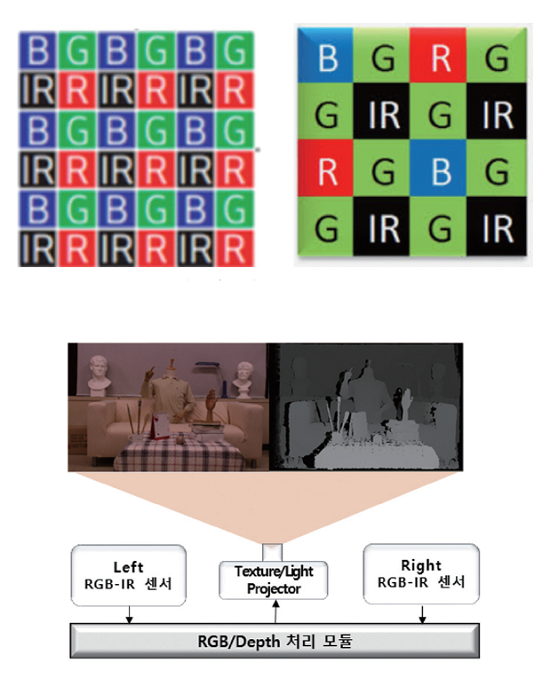

그림(6)의 왼쪽은 RGB영상과 IR(Infrared: 적외선) 영상을 동시에 입력하는 RGB-IR Bayer 패턴을 갖는 이미지 센서다. 각각은 RGB-IR을 대등하게 배치하는 구조와 RGB-IR의 파장 특성에 따라, G, IR, R/B의 순으로 가중치를 주는 다양한 픽셀 구조를 갖고 있다. RGB와 IR 영상을 동일한 픽셀로 감지하는 공통점으로 갖고 있으며, 강건한 컬러 3D Voxel 정보를 인지하는 기본 요소로 활용이 가능하다.

그림(6)의 오른쪽은 현재의 Passive 스테레오 비전 방식의 성능 한계를 극복하는 RGB-LiDAR의 구조이다. 텍스처가 없는 영역에서 Depth 정보가 열화되는 단점을 개선하기 위해, 사람의 눈에 보이지 않은 적외선 패턴을 투사한다. 이 패턴은 죄우 영상의 시차(Disparity)를 구하기 위해, 시차구간(Dispariy Range)에서 상호 분별되기 위한 투사 패턴의 Uniquess를 보장하며, 기존의 MS Kinect-1과 같이Random Dot 패턴을 사용할 수도 있다.

이제 정확히 시차가 일치하며 양질의 컬러 3D Voxel 정보를 얻기 위해 사용하는 정보는 좌우 카메라의 컬러 영상정보와 패턴이 투영된 IR 좌우 영상이다. 이 IR 영상의 패턴의 해상력에 따라 죄우 영상의 시차를 계산하여 Depth의 골격을 우선 구하고, 컬러 영상의 색정보, 위치 정보등의 고유한 특성을 활용하여, 이 Depth 영상에 살을 입히는 작업을 거치면 고품질의 Depth 영상 정보를 얻을 수 있다.

이와 같은 절차는 기존의 스테레오 비전 방식의 절차에 따라, 좌우 영상의 왜곡, 실장 오차를 보정하는 Calibration, 영상의 조명 변화를 개선하며, 시차 정보 후보를 추출하는 Raw Cost Computation 처리, RGB-IR의 영상 특성의 Uniquness를 보강하는 Cost Aggregation(Support Weight) 처리 절차 그리고 후보 픽셀의 차이가 가장 적은 것을 선택하는 Disparity Computation 처리를 거쳐, 그림(6) 좌측 상단의 흑백정보로 보인 Depth 영상을 얻을 수 있다. 여기서 보인 영상은 잡음 제거 절차를 거치지 않은 것으로 다양한 잠음제거 기술을 사용하면 보다 선명한 결과 도출이 가능하다.

여기에서는 사람의 복잡하고, 정교한 시각체계를 모사하고, 비가시광 패턴을 투사하여 분별력을 증진하는 RGB-LiDAR의 개략적인 구성형태와 동작 원리에 대해 설명했다. 이 방식은 구글/웨이모 자율자동차에 주력 거리 센서로 쓰이는 Velodyne LiDAR에 비해 거리정보에 시점이 일치하는 RGB 정보가 부가되는 장점을 갖고 있다. 현재 RGB카메라와 LiDAR를 각각 별도로 설치하는 자율이동체의 센싱 시스템의 구성을 단순화하고, 자동이동체의 구성을 단순화시키며, 기능 및 가격의 경쟁력을 확보할 수 있는 핵심 기술로 활용이 가능할 것이다.

자율이동체의 핵심 인지기능은 사람과 같이 주변환경을 3D True 컬러로 인지하는 것이다. 현재 기술은 RGB 카메라로 고해상도, 30Hz 이상 높은 프레임 레이트의 컬러영상을 회득하고, 5~20Hz 내외 프레임 레이트와 중간 해상도(1200x64)의 거리 정보는 그림(3)의 거리 측정용 LiDAR를 장착하며, 열악한 기후환경에 대비한 매우 낮은 해상도의 Radar를 기본 센서로 사용하며, 투명체를 감지할 수 있는 초음파 센서도 병행하여 사용하고 있다, 이는 각기 다른 센서간 동기화와 시점 일치 등 센서 융합이라는 복잡한 알고리즘과 높은 계산량을 필요로 해 완전 자율이동체 실현을 위한 한계로 작용한다.

여기에서 기술한 RGB-LiDAR 기술은 자율이동체의 감각인지를 위한 효율적인 하나의 요소가 될 수 있으나, 비가시 환경(연기, 안개, 먼지 우천)의 극복은 자율이동을 위한 중요한 연구분야로 집중적인 연구가 진행중이다.

이 부분은 그림(6)의 Texture/Light 투사모듈을 THz 파장, 단파적외선(Short Wave IR), 중파적외선(Mid-Wave IR), 장파적외선(Far-Wave IR) 등의 파장을 적절히 사용하면, 사람 눈 보다 강건한 완전 자율이동체를 위한 RGB-LiDAR 기술의 개발 가능성도 높다고 판단된다.

3. 맺음

우리는 3차원 공간에 살고 있으며, 여기에 시간을 더한 4차원은 사람이 실존하고 있는 현실이다, 자동차의 운전석에 앉은 운전자는 전방을 주로 주시하며, 또한 측면거울, 후면 거울, 자동차의 좌우 윈도우를 통해 시간단위로 변화하는 주변의 환경을 3차원 컬러 영상으로 인지한다.

미국 DARPA의 자율자동차의 Grand Challenge의 성공 이후, 전세계 기술자는 자율자동차의 시대가 도래한다고 주장한다. 그 시점을 짧게는 5년 뒤인 2025년, 혹자는 10년뒤인 2030년을 예측하기도 한다. 사람이 전혀 개입하지 않는 Level-5 완전자율자동차 도래 시점이 언제가 될지는 확언할 수는 없지만, 이런 물음은 할 수 있을 것 같다. 지구에서 가장 운전을 잘하는 F1의 황제 미하엘 슈마허가 내차를 운전한다면, 이 자동차는 완전 자율자동차의 운행과 같을까?. 사람이 시야를 방해하는 눈, 비, 안개, 먼지 등의 혹한 환경을 극복할 수 있을까?. 사람의 눈은 수억년의 진화를 거쳐, 지금에 이르렀고, 지금 생명체중 가장 뛰어난 시각체계를 지닌 사람의 눈도 모든 환경에서 안전하게 운전하는 것을 보장하지는 못한다. 그럼 현재의 RGB카메라, 기존 LiDAR, Radar, Sonar등의 융합은 그 대안이 될 수 있을까?

우리는 아직 실외의 다양한 환경에서 사람의 눈과 같이 총천연색으로 주변 환경을 3차원으로 감지하는 기술을 갖고 있지 못하며, 단지 2차원으로 투영한 RGB 카메라로 디지털 세상으로 재현할 뿐이다. 진정한 의미의 자율이동체는 사람의 시각에 안개, 먼지 눈, 비등의 가혹한 환경에 대처하고, 다양한 조도 환경에 적응하는 환경 적응 시각능력이 부가되어야 가능할 것이다.

지금까지 사람 눈과 같이 RGB와 Depth의 시점이 일치하며, 실환경에 적용이 가능한 성능을 담보하는 기술을 RGB-LiDAR라는 새로운 용어로 정의하고, 구조와 동작에 대해 설명했다. 또한 특정 파장을 활용해 사람이 인지가 불가능한 기혹한 환경적응을 위한 대안에 대해서도 약술하였다.

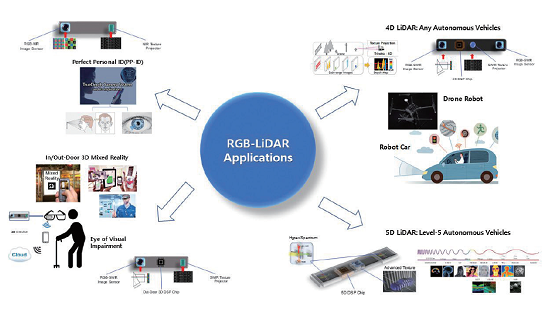

그림(7)은 지금가지 설명한 RGB-LiDAR의 일부 응용방법을 보여주고 있다. 스마트폰의 개인인증을 위한 3D 얼굴인식, 맹인의 시각보조, 3D RGB에 시간축 변이정보가 더해진 4D LiDAR가 자율이동체에 우선 적용되고, 4D LiDAR에 다중파장의 정보가 더해져 다양한 기후 및 조도 환경에 대처가 가능한 5D LiDAR 기술로 진화하여 L5 자율차를 위한 기반이 될 것으로 예측해 본다.