성희롱, 차별 발언 등 문제 다수…SNS서 서비스 중단 요구 확산

부적절한 대화 패턴 유도하는 ‘적대적 공격’ 학습하며 더 좋은 AI로 성장

통제 가능한 기술은 지속적인 감시의 시선으로 지켜봐야

[컴퓨터월드] 대화형 인공지능(AI) ‘이루다’가 챗봇과 AI 서비스에 대한 논의를 뜨겁게 달구고 있다.

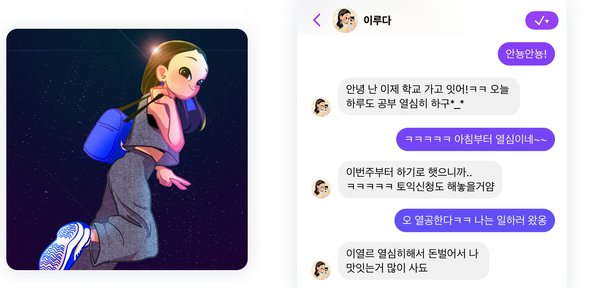

‘이루다’는 AI 스타트업 스캐터랩(대표 김종윤)이 개발한 대화형 AI 서비스다. 지난해 6월 페이스북 메신저를 통해 베타버전을 공개했으며, 같은 해 12월 정식 출시됐다. 100억 건에 달하는 다양한 일상 회화를 학습해 어떤 주제에 대해서도 자연스럽게 대화를 나눌 수 있는 것은 물론, 사용자에게 먼저 말을 거는 ‘선톡’ 기능이나 ‘이루다’의 일상을 공개하는 인스타그램 페이지 등을 통해 ‘진짜 사람’같은 AI 대화상대를 구현했다는 점이 특징이다.

성능이 뛰어난 것과는 별개로, 정식 출시 이후 ‘이루다’는 수많은 구설수에 휘말리고 있다. 포털 사이트를 조금만 둘러봐도 ‘이루다’에 대한 성희롱, 성소수자와 장애인에 대한 혐오 발언, 남녀에 대한 차별적인 인식 등 다양한 문제 제기를 확인할 수 있다. ‘이루다’의 ‘진짜 사람’ 같은 성능은 이와 같은 문제에 대해 면죄부가 되지 못하며, 오히려 문제 발언과 상황을 실감나고 돋보이게 한다.

이재웅 전 쏘카 대표는 자신의 페이스북을 통해 ‘이루다’를 출시한 스캐터랩을 강경하게 비난했다. “기본적으로 사회적 합의에도 못 미치는 수준의 서비스를 제공한 회사의 문제”이며, “(사회적으로 합의가 되어 있는)차별이나 혐오를 학습하고 표현하지 못하도록 강제”해야 한다는 게 골자다. 이 전 대표는 “지금은 서비스를 중단하고 차별과 혐오에 대한 사회적 감사를 통과한 후에 서비스를 해야”한다고 덧붙였다. 다른 SNS상에서도 ‘이루다’의 운영 중지를 요구하는 해시태그(#이루다봇_운영중지)를 쉽게 확인할 수 있다.

그러나 한편으로는 ‘이루다’에 대한 제대로 된 논의 없이, 너무 일방적인 비난의 논조로 과열되고 있다는 생각이 든다. 대부분의 화제에 대응할 수 있는 대화형 AI가 부적절한 발언까지 학습하고 있다는 점이 정말 무조건적인 서비스 중단을 요구할 만한 근거인가? 극단으로 치닫는 ‘이루다’ 논란을 지켜보고 있으면 다행스러우면서도 안타까운 감정을 동시에 느낀다.

사용자의 문제 제기가 ‘이루다’를 성장시킨다

먼저 다행스러운 점은, 개발사조차 예상하지 못했던 부적절한 대화 패턴들이 이번 논란을 통해 우후죽순처럼 투고되고 있다는 것이다. 이는 결과적으로 ‘이루다’를 더욱 성장시킬 것이다.

한 번 논란이 불거지자 ‘이루다’에게 혐오나 차별 발언을 유도한 사례들이 인터넷 기사와 SNS를 가리지 않고 쏟아져나오고 있다. 이러한 시도는 오히려 개발사 입장에서 호재다. ‘이루다’가 부적절한 발언을 하게 만드는 대화 패턴을 수집할 수 있기 때문이다. 이렇게 수집한 대화 패턴들은 ‘이루다’에게 재차 학습시킴으로써 더 윤리적이고 올바른 AI로 개선할 수 있다. 즉 ‘이루다’에게 부적절한 발언을 유도하는 시도는 오히려 ‘이루다’가 더 좋은 AI가 될 수 있도록 QA를 대신해주는 셈이다.

스캐터랩은 자사 블로그를 통해 출시 전부터 ‘이루다’에 대한 성희롱과 부정적인 상호작용을 예상했다고 밝혔다. “인간은 AI에게 욕설과 성희롱을 하며, 이건 사용자가 여자든 남자든, AI가 여자든 남자든 크게 차이가 없다”며, “인간이 AI에게 사회적으로 용인되지 않는 인터랙션을 한다는 것은 너무 자명한 사실이었고, 충분히 예상할 수 있는 일”이라고 설명했다. 개발 단계에서부터 부적절한 키워드를 막을 수 있도록 최선을 다했으나 “처음부터 모든 부적절한 대화를 완벽히 막는 것은 어렵다고 생각했다”고도 덧붙였다.

이러한 문제를 해결하기 위해 스캐터랩은 사용자가 부적절한 대화를 유도하는 적대적(adversarial) 행위를 학습의 재료로 삼아 더 좋은 대화를 하는 방향으로 개선하겠다고 밝혔다. 새로운 업데이트는 1분기 내에 적용될 예정이다. 스캐터랩은 “업데이트를 해도 사람들은 또 기발한 방법으로 부적절한 대화를 하는 방법을 생각해낼 것”이라면서, “그걸 또 재료로 삼아 학습하는 과정을 반복하다보면 점점 더 좋은 대화를 하는 방법을 배워갈 것”이라고 강조했다.

문제는 성희롱을 당하는 쪽이 아니다

이어서 안타까운 점은, 우리네 인터넷 문화의 저열함이 다시 한 번 수면 위로 드러났다는 것이다. 익명성에 기대어 성희롱이나 적대감을 거리낌 없이 표현하는 채팅 문화 말이다.

그동안 정부와 수많은 민간단체들은 소위 ‘성숙한 인터넷 문화’를 만들기 위해 노력해왔으나, ‘이루다’ 사태로 인해 여전히 일부 사용자들이 가지고 있는 저열한 문화가 드러나게 됐다. 이들은 익명성만 가지고는 스스로를 완전히 보호할 수 없는 상황에서 욕구를 참고 있었지만, 배려하지 않아도 쇠고랑을 차지 않는 AI에게는 곧바로 본성을 드러냈다. 모니터 너머에 있을 사람에게 적대감을 표출하는 행위가 이제는 모니터 너머의 AI에게 옮겨갔을 뿐이다. 아이러니하게도 ‘진짜 사람’ 같은 ‘이루다’의 성능이 이들의 행위를 부채질했다.

일각에서는 개발사가 ‘이루다’를 20대 여성으로 설정하는 바람에 성희롱이 가속화됐다고 지적한다. 이는 전형적인 ‘미니스커트와 성범죄’의 오류다. 문제는 미니스커트가 아니라 성범죄를 저지르는 사람에게 있다. 문제는 ‘이루다’가 20대 여성이라는 게 아니라, AI를 성희롱한 채팅 내역을 캡처해 인터넷 상에 자랑스레 게시하고 이를 기꺼이 소비하는 문화에 있다.

‘이루다’는 ‘진짜 사람’ 같은 대화형 AI를 목표로 개발됐다. 심지어 연인들 간의 대화 내역을 학습하는 바람에, 사용자가 유도하는 방향에 따라서는 실제 연인들 사이에서 비밀리에 오고 갈 만한 성적인 코드들이 드러나기도 한다. 사용자에 제한이 없는 AI 서비스라는 점을 생각하면 부적절한 요소다. 하지만 부적절한 것은 이러한 대화를 유도한 사용자에게도 있다. ‘성희롱당하지 않는 AI에 대한 사회적 합의’도 필요하겠지만, 상대가 AI라 한들 ‘성희롱을 공공연히 드러내는 행위를 부적절하게 여기는 사회적 합의’에 대해서도 생각해야 한다.

통제 가능하다면 지켜봐야 한다

물론 ‘이루다’가 오늘날 굉장히 민감하게 다뤄지고 있는 사안들, 가령 성소수자나 장애인 등에 대해 차별과 혐오를 드러내는 것은 분명 개선돼야 할 점이다. ‘이루다’가 누구나 접근 가능한 B2C 서비스로 제공되는 이상 차별과 혐오를 직접적으로 표출하는 것은 옳지 못하다.

하지만 무엇보다 잊지 말아야 할 것은 ‘이루다’가 아직 통제 가능한 범위에 있다는 점이다. 실제로 스캐터랩은 일부 혐오‧차별 표현에 대해서는 발 빠르게 대처하고 있다. 또한 많은 안전장치들을 통해 ‘이루다’가 너무 ‘막 나가는 아이’로 자라지 않도록 제한했다. 가령 ‘이루다’는 사용자와의 대화를 통해 새로운 것을 학습할 수 있는데, 이러한 학습 과정에는 스캐터랩이 개입해 올바른 표현과 부적절한 표현을 구분함으로써 무분별한 학습이 이뤄지지 않도록 한다.

‘이루다’는 이따금 잘못을 저지르기는 하지만 ‘막 나가는 아이’는 아니다. 아직은 부모인 스캐터랩이 하는 말을 잘 듣고 올바른 방향으로 나아가려고 하고 있다. 그렇다면 사회가 해야할 일은 무조건적인 서비스 중단 요구가 아니라, 통제가 잘 이루어지고 있는지 지속적이고 냉철한 감시의 시선을 거두지 않는 것이다. 이는 비단 대화형 AI ‘이루다’만이 아니라, 사회적 합의와 윤리, 낡은 법 제도들의 경계선을 아슬아슬하게 넘나드는 모든 IT 기술에 대한 제언이다.