버즈니 남성욱 커머스AI 리서치 엔지니어

[컴퓨터월드]

1. 개요

버즈니가 운영하는 홈쇼핑모아는 국내 모든 홈쇼핑 채널의 상품들을 하나의 공간에 모아 사용자가 홈쇼핑에 쉽게 접근할 수 있게 도와주는 모바일 홈쇼핑 플랫폼이다.

홈쇼핑모아에 방문하는 사용자의 앱 사용 시나리오 중 가장 큰 비중을 차지하는 검색 영역은 1억 개가 넘는 상품 중 사용자가 원하는 상품을 상위에 노출할 수 있도록 설계되어 있다. 홈쇼핑모아의 검색시스템은 지금 이 순간에도 조금이라도 더 좋은 검색 결과를 내기 위해 여러 방면에서 검색모델을 개선하고 있다.

이번 기고에서는 홈쇼핑모아의 검색모델을 개선하기 위한 여러 시도 중 한 가지인 ‘상품의 시즈널 특성을 반영해 보자’에 대해 정리해 보려고 한다. ‘시즌널 특성’이 반영되어야 하는 이유부터 모델 설계과정, 결론까지 순서대로 살펴보도록 하겠다.

2. 시즈널 예측 모델의 필요성

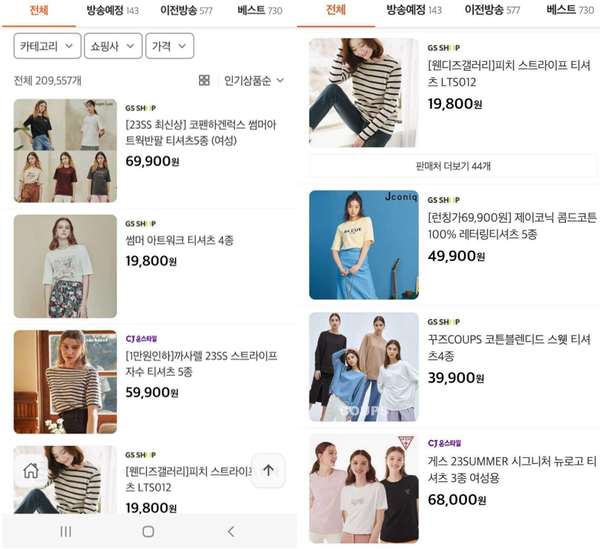

검색에 있어서 시즈널 특성에 대한 이해가 왜 필요한지 살펴보도록 하자. 아래 <그림 2>는 ‘티셔츠’라는 쿼리로 나올 수 있는 상품들의 예시다.

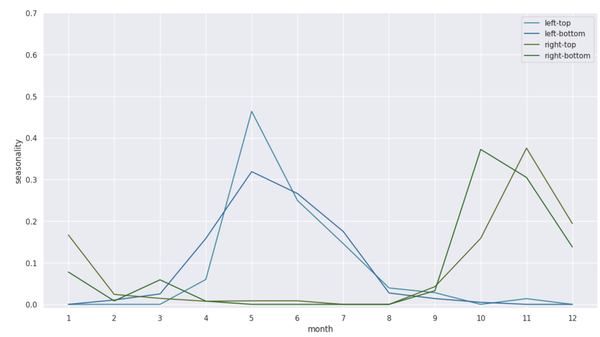

보는 바와 같이 같은 ‘티셔츠’ 상품임에도 입는 계절이 다른 상품들이 다수 존재한다. 따뜻한 여름에 입을 수 있는 얇은 소재의 티셔츠부터 추운 겨울에 입을 수 있는 두꺼운 소재의 티셔츠까지 다양하다. 티셔츠 이외에도 입학 시즌이 가까워지면 책가방, 취업 시즌이 가까워지면 정장, 추석 설날이 가까워지는 시즌에는 명절 음식 등 시즌마다 사용자가 홈쇼핑에서 찾는 상품은 서로 다르다. 이러한 상품들을 해당 시즌에 맞게 더 상위에 노출할 수 있다면 훨씬 더 만족스러운 검색시스템이 될 것임이 분명하다. 티셔츠 상품의 월별 판매 비율을 나타내면 아래 <그림 3>과 같다.

3. 모델 설계 - 데이터

모델을 설계하기 위해 아마존(Amazon)에서 2022년에 발표한 <Seasonal Relevance in E-Commerce Search> 논문을 참고했다. 해당 논문에서 아마존은 ‘The online A/B test on 784 MM queries shows the treatment with seasonal relevance features results in 2.20% higher purchases and better customer experience overall’라고 설명했는데, 이전보다 주문량이 2.2% 늘어났고 사용자에게 더 좋은 사용 경험을 제공할 수 있게 되었다고 설명하고 있다. 여기에서는 그 이상의 효과를 기대하며 모델을 설계해 보도록 해보자.

홈쇼핑모아는 모든 홈쇼핑사의 데이터를 한곳에서 확인할 수 있어 데이터 부분에서 큰 강점을 가지고 있다. 홈쇼핑상품 판매 데이터에 대한 로그 역시 대량으로 DB에 적재되고 있다. 이를 정제하는 것으로 모델 설계의 첫 단추를 잘 끼워보려고 한다.

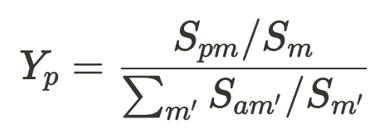

먼저 참고할 논문에서 언급한 대로 월 단위로 데이터를 정리할 필요가 있다. 데이터를 정리하고 난 후 매월 매출액을 이용해 관련 수식을 계산하고 최종적으로 상품명→Y_p(seasonality of product p)라는 데이터셋을 구성할 수 있게 됐다.

여기서 S_m은 m월의 총 판매량, 그리고 S_pm은 상품 p의 m월의 총판매량을 의미한다.

추가적으로 몇 가지 미세한 처리들이 필요했다. 홈쇼핑 특성상 특정 시기에 갑자기 많이 팔리는 상품들이 있는데, 이는 방송상품으로 특정 기간에 갑자기 매력적인 가격, 구성으로 판매하는 경우다. 이러한 상품들은 상품의 시즌성을 학습하는 데 있어 큰 노이즈로 작용할 것이므로 선별해 내는 작업이 필요했다.

4. 모델 설계 - 모델 구성

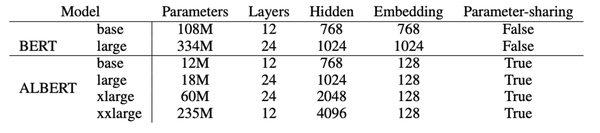

홈쇼핑모아에서는 기본적인 NLP 업무(task)에 ALBERT를 활용하고 있다. ALBERT는 BERT의 경량화 모델이다. 상대적으로 높은 정확도와 가벼운 모델로 서비스에 적용하기 쉽다.

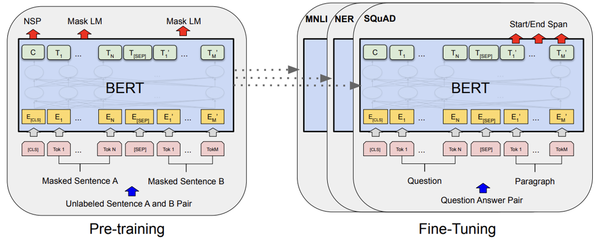

여기서 BERT는 다양한 NLP 업무를 쉽게 풀 수 있게 도와주는 대규모 언어모델이다. 우리가 사용하려하는 ALBERT는 BERT의 구조를 따르되 몇 가지 차별점을 가지고 있다.

임베딩(embedding) 과정에서 Factorized embedding parameterization, transformer layer 간의 패러미터를 공유하도록 설정하고(Cross-layer parameter sharing), 적은 패러미터로도 언어적 의미를 쉽게 학습할 수 있도록 로스(loss)를 고도화(inter-sentence coherence loss)하는 것 총 세 가지로 그 차별점이 요약될 수 있다. 홈쇼핑모아에서는 이러한 ALBERT를 1억 개의 상품명 데이터를 이용해 홈쇼핑 도메인에 맞는 언어모델로 사전학습을 시켰다.

사전학습된 ALBERT 기반의 파인 튜닝을 통해 상품의 시즈널리티(seasonality)를 예측하는 모델을 얻었다. 위에 정리한 데이터를 구성한 것과 같은 맥락에서 마지막 레이어는 각 유닛이, 해당 월의 관련성(relevance)을 의미할 수 있도록 12개의 유닛을 갖도록 구성했다. 멀티-라벨(multi-label) 문제이지만, 데이터셋을 구성할때 라벨이 확률분포(probability distribution)를 따른다고 가정하고 마지막에 softmax 함수를 사용한다.

5. 검색 랭킹에서의 활용

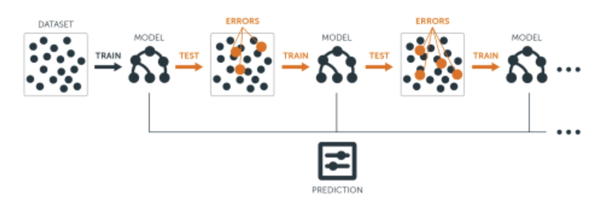

홈쇼핑모아에서는 검색된 상품들의 순서를 리랭킹하기 위해 ‘LambdaMART’를 사용하고 있다. 여기서 ‘람다MART gradient boosting model’ 계열의 모델로 일반적인 부스팅 모델의 loss function을 리랭킹이라는 업무에 맞게 변형한 모델이다<그림 6>. 따라서 일반적인 머신러닝 모델처럼 데이터를 일반화해 학습할 수 있도록 다양한 관점에서 피처(feature)를 확보하는 것이 중요하다.

위에서 학습한 상품의 시즈널리티를 LambdaMART에 활용하면 된다. 서비스되고 있는 시즌과 같은 시즌의 확률을 피처로 활용하면 그림이 딱 맞아진다. 참고하고 있는 아마존의 논문에서도 역시 LambdaMart의 피처로써 위에서 계산한 상품의 시즈널리티를 활용하고 있다. 이 시즈널리티를 그대로 모델에 넣는 것이 아니라 한번 후처리를 거친다.

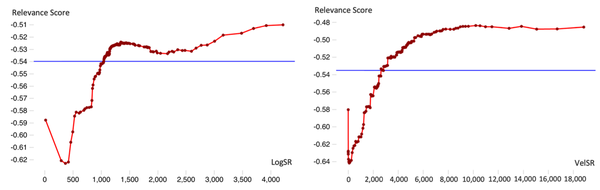

(1) LogSR

- a scaled log transformation of seasonal relevance

(2) VelSR

- a composite feature combining seasonal relevance with sales velocity, with the motivation to consider the products' inherent seasonal attributes, as well as the changing and sometimes hard-to-predict dynamics

위 두 가지 선택지 중, 랭킹스코어에 더 monotonic하게 반응하는 VelSR을 최종적으로 선택했다. 홈쇼핑모아에서도 역시 이러한 sensitivity 분석을 통해 설명할 수 있는 변수를 LambdaMART 피처로써 설계해 나가고자 한다.

6. 결론

이번 기고에서는 상품 시즌성을 반영한 검색 결과 리랭킹 방법에 대해 정리했다. 아마존의 래퍼런스를 따라 데이터셋을 구성할 수 있었고, 다양한 NLP 업무를 효과적으로 습득하고 활용할 수 있는 BERT를 통해 모델을 구성할 수 있었다. 끝으로 LambdaMART 피처로써 리랭킹에 활용하는 것으로 ‘시즌성을 반영한 검색 결과 리랭킹’이라는 테스크의 전체 구조를 그릴 수 있었다.

현재 버즈니는 빠른 시일 내에 상품 시즌성을 포함해 검색 리랭킹을 서비스에 반영하는 것을 목표로 하고 있다. 시즌성 이외에도 리랭킹을 위해 활용할 수 있는 다양한 요소들을 지속적으로 찾아 적용해 이용자가 원하는 상품들을 더 상위에 올려줄 수 있는 검색시스템을 구축해 나가려고 노력 중이다.